DEAP: A Database for Emotion Analysis using Physiological Signals 리뷰

HCI 시스템에 대해 많은 연구가 진행되었음에도, 시스템은 여전히 억양, 표정, 제스처 등의 비언어적 단서를 제대로 해석하지 못해 감정 정보를 해석하고 행동에 고려하는 능력이 부족합니다.

최근 많은 시스템에서 인간의 감정을 데이터로서 다루고 있습니다. 이 연구에서 든 예시인 멀티미디어 콘텐츠의 경우 설명을 붙이거나 정보를 검색하는데 정서적 특성을 반영하는 것이 중요하다고 주장하며, 감정 정보를 사용하면 콘텐츠 검색-추천 시스템의 성능이 개선될 수 있을 것이라 기대하고 있습니다.

하지만 감정 정보를 잘 활용하고 시스템에 적용하기 위한 생리학적인 근거나 컴퓨팅 데이터가 부족했고, 이러한 데이터를 획득하는 것이 이 연구의 목표로 설정되었습니다.

결과적으로 이 연구는 이러한 기대를 자원봉사자 32명의 EEG 뇌파 데이터, 말초 생리 신호, 뇌파 측정 당시의 감정 상태, 얼굴 표정 비디오를 기록하여 데이터 사이의 연관성을 평가하고 일련의 데이터를 멀티모달 데이터셋으로 구성하여 공개하였습니다.

감정 유형 구분 방법

이미 감정의 유형을 구분하려는 시도는 다양하게 존재합니다. 여기서는 Ekman과 Friesen의 6개 기본 감정(The six basic emotions), Parrot의 감정 나무 구조(The tree structure of emotions)과 Plutchik의 감정 바퀴(The emotion wheel), Russell의 쾌락조-각성 척도(The valence-arousal scale)과 같은 척도를 소개했습니다.

이 연구에서는 쾌락조-각성 척도를 감정 유형 구분 방법으로 선택했는데, 감정을 정량적으로 평가하는데 널리 쓰이고 2차원 평면으로 표현 가능한데다 주체감(dominance)를 추가하여 3차원 평면으로 활용할 수도 있기 때문입니다.

감정 자극 유형과 음악 선정

이 연구에서는 감정 기반 음악 추천 시스템을 구현하는 것을 시나리오로 잡았기 때문에, 연구 전반에 음악과 뮤직비디오가 활용되었습니다.

감정 자극 유형은 여러 단계에 걸쳐 선택되었는데, 처음에는 반자동 60개, 수동 60개를 선정한 후 점차 제거하는 식으로 진행했습니다.

반자동 처리에는 Last.fm의 음악 태그를 활용했는데, 감정을 표현하는 60개의 키워드를 선택한 후 이 키워드를 근거로 1084곡을 선정, 강조 알고리즘을 활용하여 1분 길이의 하이라이트를 추출했습니다.

추출한 하이라이트는 자원봉사자들이 직접 시청하고 9점 만점의 평가를 시행하여 40개 비디오를 선정했습니다.

실험 설정과 절차

참가자는 시스템에 적응하는 시간을 가진 후 다음과 같은 순서로 40개의 비디오를 평가했습니다.

- 2초간 현재 평가 번호를 확인한다.

- 5초간 기록을 위해 영점을 잡는다.

- 1분간 뮤직비디오를 시청한다.

- 본인의 쾌락조, 각성, 호감, 주체감을 자기평가한다.

- 20회 시행 후 잠시 휴식을 갖는다.

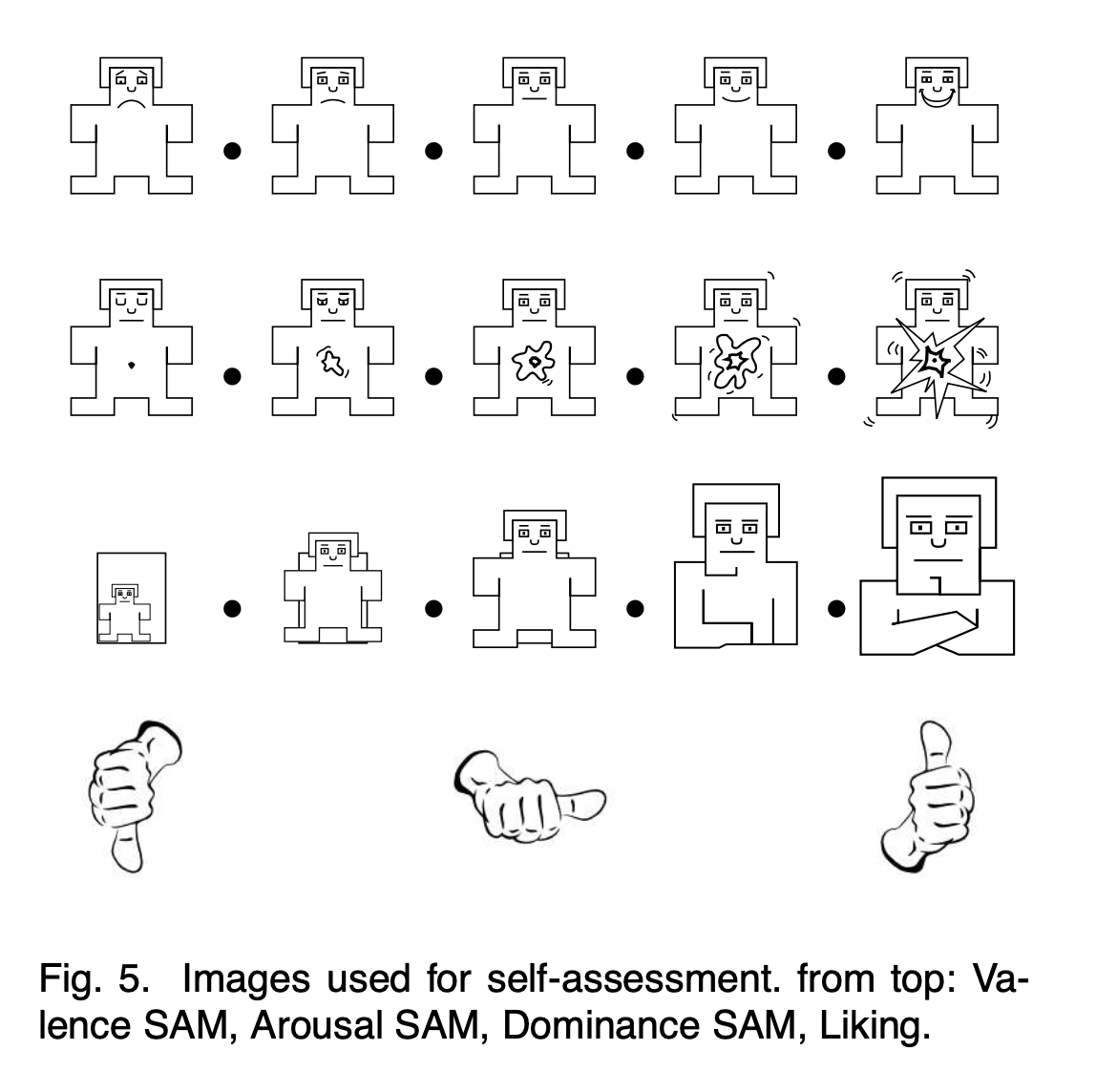

평가에 쓰인 설문지의 항목입니다.

- 쾌락조: (5개 척도) 슬픔/불행 ~ 즐거움/행복

- 각성: (5개 척도) 편안함/지루함 ~ 자극받음/흥분됨

- 주체감: (5개 척도) 무력함 ~ 주체적임

- 호감: (3개 척도) 개인적인 선호를 의미하고, 쾌락조와 혼동해서는 안됨을 사전 고지함

감정상태 자기평과 결과 분석

모든 자극은 쾌락조-각성 사분면 위에 배치할 수 있는 것만을 선정했으므로, 낮은각성-낮은쾌락(LALV), 높은각성-낮은쾌락(HALV), 낮은각성-높은쾌락(LAHV), 높은각성-높은쾌락(HAHV)으로 구성된 쾌락조-각성 사분면 상에서 분석할 수 있습니다.

Wilcoxon 부호-서열 검정 결과, 각성 수준과 쾌락조 수준이 상호의존적, 다시 말해 서로 다른 각성 수준이 서로 다른 쾌락조 수준을 유도하는 것을, 역으로 서로 다른 쾌락조 수준이 서로 다른 각성 수준을 유도하는 것을 확인했습니다.

또 낮은 각성 범위(LA; Low Arousal)의 값은 “덜 성공적”으로 측정되었는데, 범위 내에서 평균적으로 높은 수준의 각성 수치를 보이고 쾌락조가 크게 구분되지 않았습니다.

이에 반해 높은 각성 범위(HA; High Arousal)에서는 값이 잘 구분되어 전반적으로 C 모양의 분포를 보였습니다.

이러한 분포는 잘 검증되었다고 알려진 IAPS(International Affective Picture System), IADS(International Affective Digital Sounds System)와 비슷합니다.

데이터는 참여자별로 큰 다양성을 보였는데, 이것은 음악적 취향, 평소 기분 상태, 감정 해석 방법에 있어 개인차가 있기 때문이지, 데이터가 부적절한 것은 아니라고 합니다.

결과적으로 LA 환경에서는 부분적인 편향이 존재하지만 감정은 성공적으로 유도되었고, 호감도와 주체감이 제한된 범위의 쾌락조 상에서 높은 수준의 상관관계가 관찰되었습니다.

그 외의 척도들은 약하거나 중간 수준의 상관관계를 보이는데, 이는 참가자들이 각 척도들을 잘 구별한 덕분입니다.

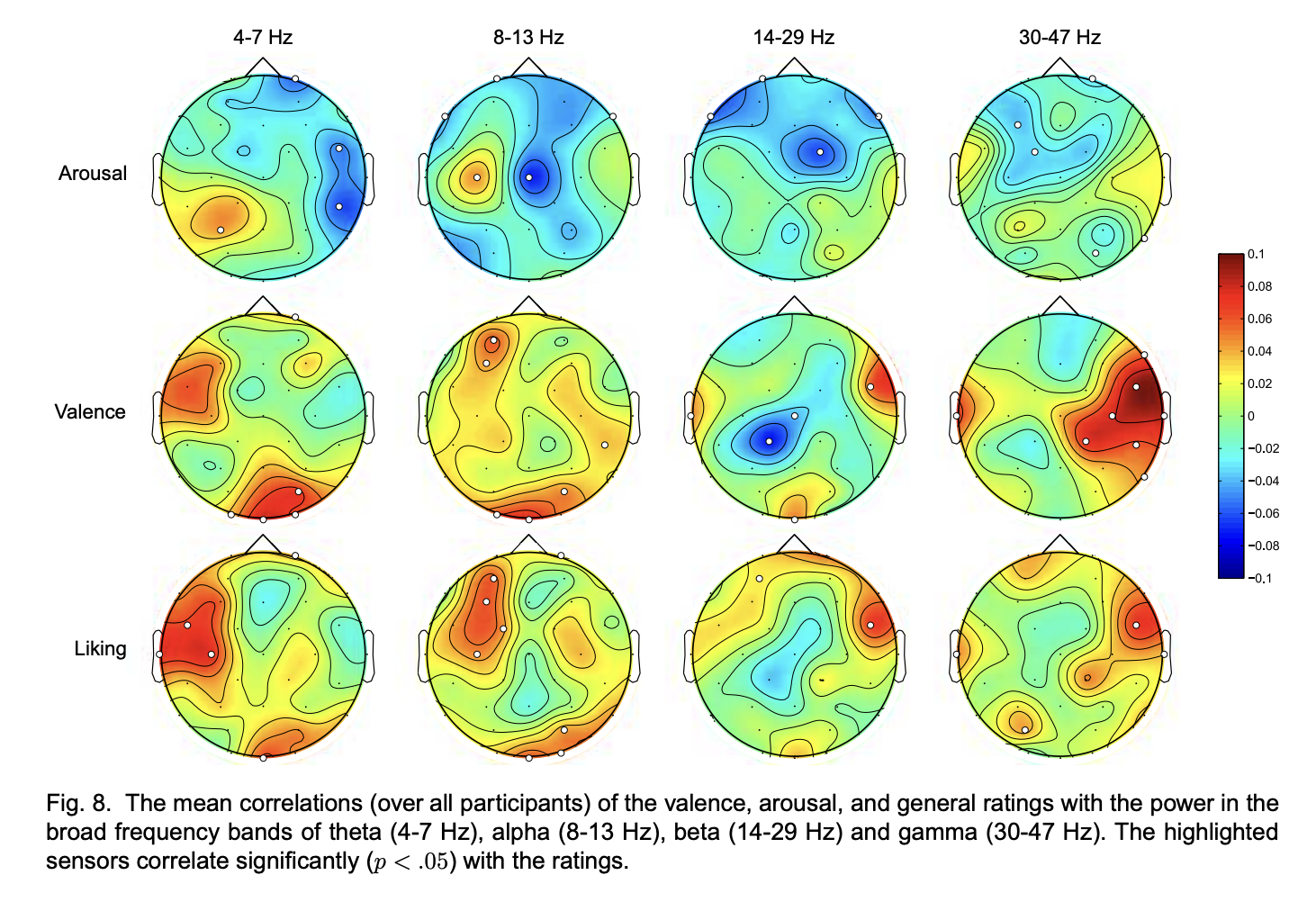

EEG와 감정상태 자기평가 결과의 상관관계

연구에서는 EEG와 참가자가 자기평가한 감정 상태의 상관관계를 확인하기 위해 3~47Hz의 구간 신호를 추출했습니다.

이것은 확인하고자 하는 감정 상태가 세타(3~7Hz), 알파(8~13Hz), 베타(14~29Hz), 감마(30~47Hz) 주파수와 연관되기 때문입니다.

- 쾌락조는 EEG 신호와 가장 큰 양의 상관관계를 보임

- 모든 주파수 대역과 상관관계를 확인함

- 쾌락조가 증가하면 세타와 알파 주파수가 강해짐

- 참가자가 소리에 집중하게 되면, 시각 피질이 위치한 후두부의 활동이 억제되거나 비활성화됨

- 후두부와 우측 측두엽에서의 베타 주파수가 강해짐

- 긍정적 감정의 유도와 외부 자극과 연관

쾌락조와 전측두엽에서 베타와 감마 대역의 고주파가 양의 상관관계를 보임

근육 활동은 전방과 측두 전극에서 두드러짐

- 모든 주파수 대역에서 선호도와 상관계 발견함

- 전두엽에서의 세타, 알파 대역 증가

- 좌측 알파 세기의 증가가 높은 호감도로 촉발되는 좌전두 활성과 충돌됨

- 이 범위의 피질에서 알파 대역의 세기를 낮추도록 유도됨

각 시행에 대한 분류

연구에서는 각 시행마다 각성, 쾌락조, 호감도의 수준이 높은지, 혹은 낮은지 이진 분류하기 위해 세 가지 방법을 사용했습니다. EEG 신호를 이용한 분류, 말초 신경계의 신호를 이용한 분류, MCA를 이용한 분류입니다.

이진 분류의 임계값은 단순히 중간값으로 설정했는데, 이 때문에 분류가 균형있게 이루어지지 않을 가능성이 있었습니다. 실제로 수집한 데이터를 이진 분류한 결과 높은 각성, 쾌락조, 호감도는 각각 59%, 57%, 67%로 다소 불균형했습니다.

이 때문에 분류에는 F1 점수와 가우시안 나이브 베이즈 분류기(Gaussian Naive Bayes Clasifier)를, 특징 추출에는 Fisher의 선형판별분석 (Fisher’s Linear Discriminant) 사용했습니다.

\(J(f) = |\mu_1 - \mu_2| / (\sigma_1^2 + \sigma_2^2)\) \(G(f_1, ..., f_n) = \underset{c}{\text{argmax}}\ {p(C=c)\prod_{i=1}^{n}{p(F_i = f_i | C = c)}}\)

EEG와 말초 신경계

말초 신경계 신호는 갈바니 피부 반응(GSR; Galvanic Skin Reponse), 호흡 진폭*(Respiration Amplitude), 피부 온도, 혈액량, 근전도와 안구전도를 이용하였습니다.

*호흡 진폭: (=호흡 속도) 호흡 간격을 5%~95% 수준에서 추출한 것

- GSR: 중지와 검지 말단의 피부 저항 측정

- 혈액량: 엄지손가락의 혈액량 측정

- 근전도

- 광대: 표정 표현을 위해 움직이므로 측정

- 승모근: 웃을 때 승모근이 움직이므로 측정

- 안구전도: 눈의 깜박임이 불안과 관련이 있어 측정

측정한 값은 512Hz로 샘플링하였지만, 연구에서 데이터를 처리하고 분석할 때는 처리 속도를 위해 256Hz로 다운샘플링하였습니다.

MCA

조명 키와 색 분산, 소리는 감정 유도에 중요한 역할을 합니다. 이를 이용하기 위해 프레임의 밝기나 색상 정보, 소리도 추출하였습니다.

조명 키의 추출은 HSV 색상에서 V의 평균과 V의 분산을 곱하여 수행하였고, L, U, V의 공분산 행렬식을 계산하여 색 분산을 획득했습니다.

빠르게 움직이는 장면, 사물의 움직임도 흥미를 유발하게 되므로 B-frame과 P-frame에 대해 모션 벡터의 크기를 누산하여 판단 요소로 사용하였습니다.

소리의 경우 음량은 각성과, 리듬과 평균 피치는 쾌락조와 관련이 있습니다.

이를 활용하기 위해 44.1kHz로 샘플링한 MPEG-3 오디오로 인코딩, 동일한 진폭으로 정규화한 후 특징값을 MFCC*와 Praat를 사용하여 추출하였습니다.

* MFCC: Mel Frequency Cepstral Coefficients

단일 모달 병합하기

여러 개의 단일 모달을 추출한 이유가 분류 성능을 높이고자 한 것이므로, 모달 병합으로 최종 출력을 산출하였습니다.

\[c^*=\underset{i}{\text{argmax}}{\bigg\{ \prod_{m=1}^{M}{P_i(X|\lambda_m)^{a_m}} \bigg\}}\]- $M$: 모달의 개수

- $\lambda_m$: $m$번째 모달의 분류기

$P_i(X \lambda_m)$: $i$번째 클래스의 출력 - $a_m$: 가중치

- $0 \le a_m \le 1$

- $\sum^{M}_{m=1}a_m=1$

마무리

이 연구는 컴퓨터과학과 관련되어있기도 하지만 심리학 지식도 요구하기 때문에 읽고 이해하는데 꽤 시간이 걸렸습니다.

이 연구에서의 목표는 감정 분석을 위한 데이터베이스를 구축하는 것에 있었습니다. 개인적으로 감정 유도 방법이 생각보다 허술해서 실험 자체가 막연하게 낙관적으로 이루어진 것이 아닌가 우려했는데, 데이터 분석 결과를 보니 기우였던 것 같습니다.

우려와 달리 실험 과정에서 기록된 각종 데이터가 지금까지의 연구 결과와 잘 맞는다는 사실은 인상깊은 것 같습니다.

뮤직비디오를 통해 감정을 유도하는 것은 심리학에서의 미러링에 기반한 것 같은데, 자세한 검증이나 이론적 근거 찾기는 이 연구가 참조하고 있거나 이 연구를 참조하는 다른 연구를 확인해봐야할 것 같습니다.

이 논문이 통과되고 데이터가 받아들여질 수 있는 이유는 데이터의 검증이 구체적이고 자세하게

또 다른 흥미로운 사실은 EEG를 512Hz로 샘플링했음에도, 실제로 데이터 분석 시에는 256Hz로 다운샘플링하고 분석했다는 것입니다.

데이터 처리 효율을 높이기 위함이라는데, 이 연구의 목적이 데이터베이스를 구축하는 것에 있었으므로 실제 활용 여부와 무관하게, 우선 가능한 가장 높은 해상도로 데이터를 기록한 것으로 보입니다.

이 연구는 발표되고 꽤 시간이 지났으므로 이 데이터베이스를 이용해 다양한 연구가 이루어졌을텐데, 다른 연구에서는 이 데이터를 어떻게 다루는지 확인해봐야할 것 같습니다.